opencode

opencode 是一个专为终端设计的 AI 编程代理(AI coding agent),旨在提供类似 Claude Code 的功能。支持 OpenAI、Google、Anthropic 等模型,甚至本地模型。

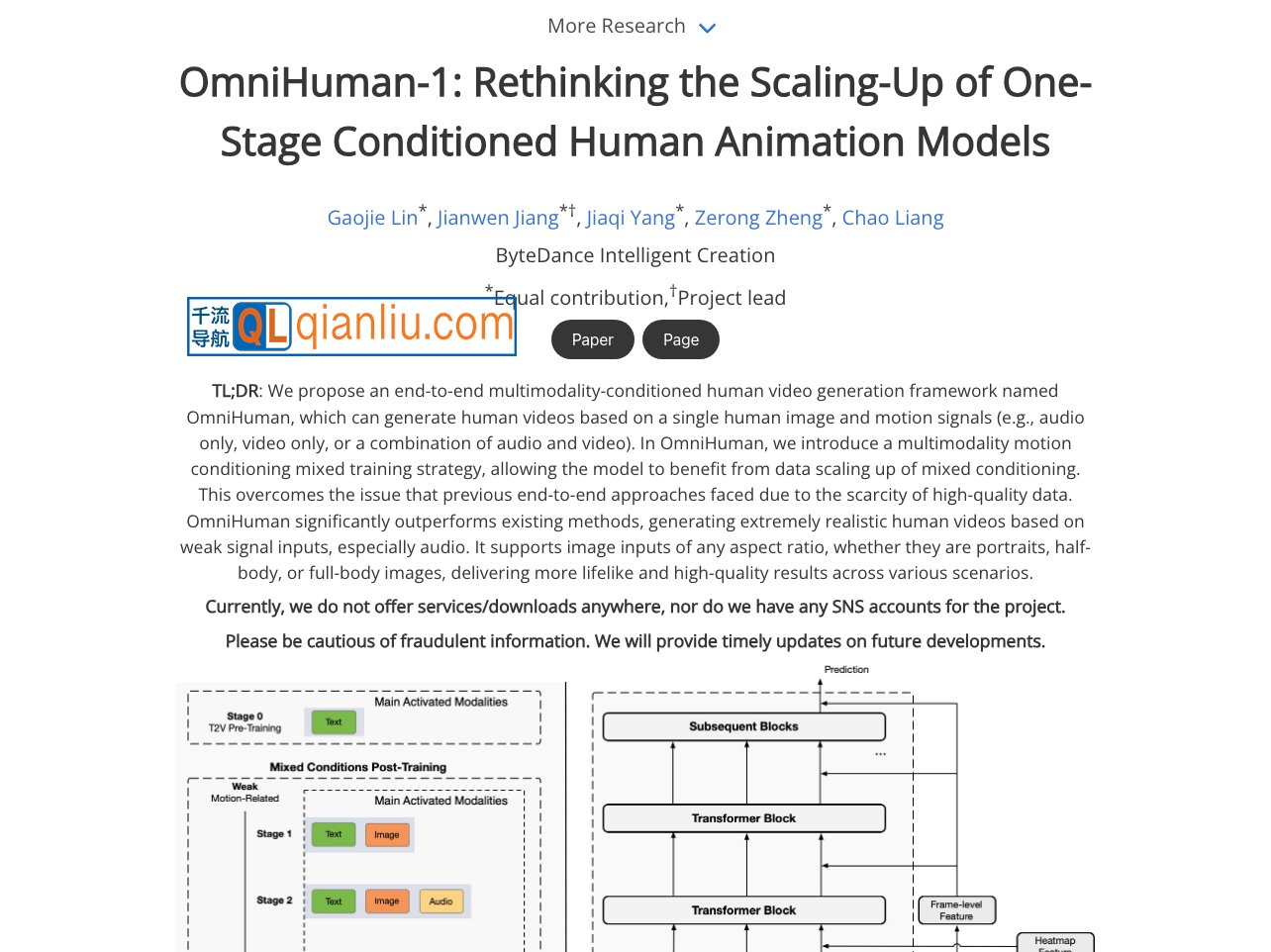

OmniHuman 是由字节跳动研发的端到端多模态 AI 数字人生成框架,能够基于单张静态人物图像与音频输入(包括语音、音乐等),自动生成高保真度的全身动态视频。该系统可同步还原人物的口型、表情、手势及身体动作,适用于说话、演唱、演奏等多种表现形式。

OmniHuman官网入口网址:https://omnihuman-lab.github.io

技术实现方面,OmniHuman 在训练阶段融合文本、音频、姿态等多种运动信号,增强模型对弱驱动条件(如仅有音频)的响应能力;同时支持任意宽高比的图像输入,在保留原始视觉风格的前提下生成协调的动作序列。此外,系统不仅限于音频驱动,亦可接受姿态或视频作为驱动源,拓展了动画生成的灵活性。

典型应用场景包括:

OmniHuman 推动了 AI 数字人技术从局部(如面部或上半身)向全身高保真视频生成的演进,为内容创作者和行业应用提供了高效、低成本的解决方案。该工具已在 千流导航 收录,便于用户快速了解与使用。