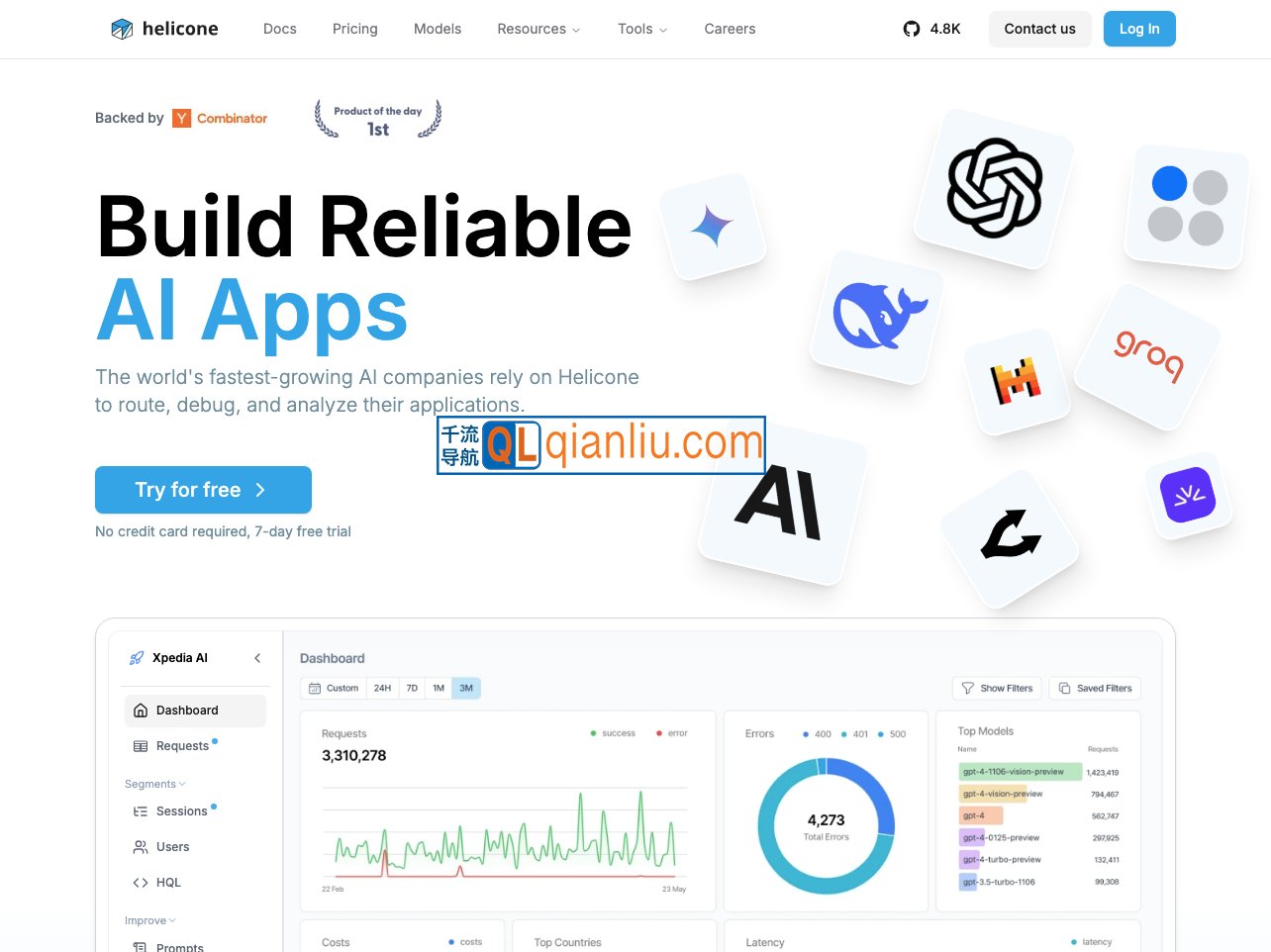

Helicone 是一个开源的 LLM(大语言模型)可观测性平台,面向开发者提供对 AI 应用的监控、调试与性能优化能力。该平台通过代理(Proxy)模式实现低侵入式集成,支持对 LLM 请求的全链路追踪与分析,适用于需要提升 AI 应用稳定性和可维护性的技术团队。

Helicone官网入口网址:https://www.helicone.ai

一、核心定位

Helicone 为 AI 应用在生产环境中的运行提供可观测性支撑,帮助开发者在不大幅修改现有代码的前提下,实时掌握请求延迟、Token 消耗、成本分布等关键指标,从而构建更可靠、可控的 AI 系统。

二、核心功能

1. 全链路可观测性

- 追踪每个 LLM 请求的完整生命周期,包括响应时间、Token 使用量及费用估算。

- 支持按会话(Session)或智能体(Agent)维度进行调试,并提供交互式 Playground 用于复现和分析输出结果。

2. 提示词版本管理与评估

- 内置提示词实验(Experiments)功能,便于对比不同版本在真实场景下的表现差异。

- 集成 LastMile、Ragas 等评估工具,支持自动化衡量生成内容的质量、相关性与准确性。

3. 统一网关与运行优化

- 作为统一入口,兼容 OpenAI、Anthropic、Gemini 等 100 余家主流 LLM 服务提供商。

- 提供智能缓存、负载均衡及自定义路由策略,有效降低调用延迟与运营成本。

- 内置速率限制、敏感信息过滤等安全机制,满足 SOC 2 与 GDPR 合规要求。

4. 数据可视化与协作

- 提供多维度仪表盘(Dashboard),可按用户、模型、时间段等条件分析成本与性能趋势。

- 支持将原始日志导出至 PostHog 等外部分析平台,便于构建定制化监控体系。

三、部署与使用方式

- 支持云托管(Helicone Cloud)与自托管两种部署模式,适配不同安全与运维需求。

- 免费计划包含每月 10 万次请求额度,超出部分按实际用量计费。

- 企业版提供角色权限管理、操作审计日志等高级功能,适合中大型团队使用。

四、典型应用场景

Helicone 特别适合以下场景:

- 希望以最小代码改动快速接入 LLM 监控能力的开发团队;

- 正在进行提示词迭代并需量化效果的 AI 产品团队;

- 同时使用多个 LLM 供应商,寻求统一管理与成本控制的企业。

凭借“一行代码即可集成”的设计,Helicone 降低了 AI 应用的运维门槛。其模块化架构(如独立的 AI 网关组件)兼顾灵活性与可控性,被 ThoughtWorks 列为值得关注的 LLM 运维工具之一。