Xinference 是一个开源的 AI 模型部署与推理框架,专注于简化大模型的部署、运行及调用过程。该框架支持多种模型类型,涵盖大语言模型(LLM)、多模态模型以及语音识别模型,并具备高性能、分布式和跨平台的推理能力。

Xinference官网入口网址:https://inference.readthedocs.io/zh-cn

在部署方面,Xinference 提供本地安装、容器化及 Docker 等多种方式,兼容 CPU、GPU 以及 Apple M 系列芯片等多种硬件环境。其核心特性包括对多类模型的支持、灵活的量化选项、跨硬件适配能力、分布式推理架构、统一的 API 接口以及自动化的模型管理机制。

技术集成与性能优化

Xinference 兼容多个主流推理引擎,如 vLLM、TensorRT、Transformers 和 llama.cpp,可有效提升推理效率。同时,该框架能够与 LangChain、LlamaIndex 等开发工具链协同工作,便于构建复杂的 AI 应用系统。

使用方式与交互接口

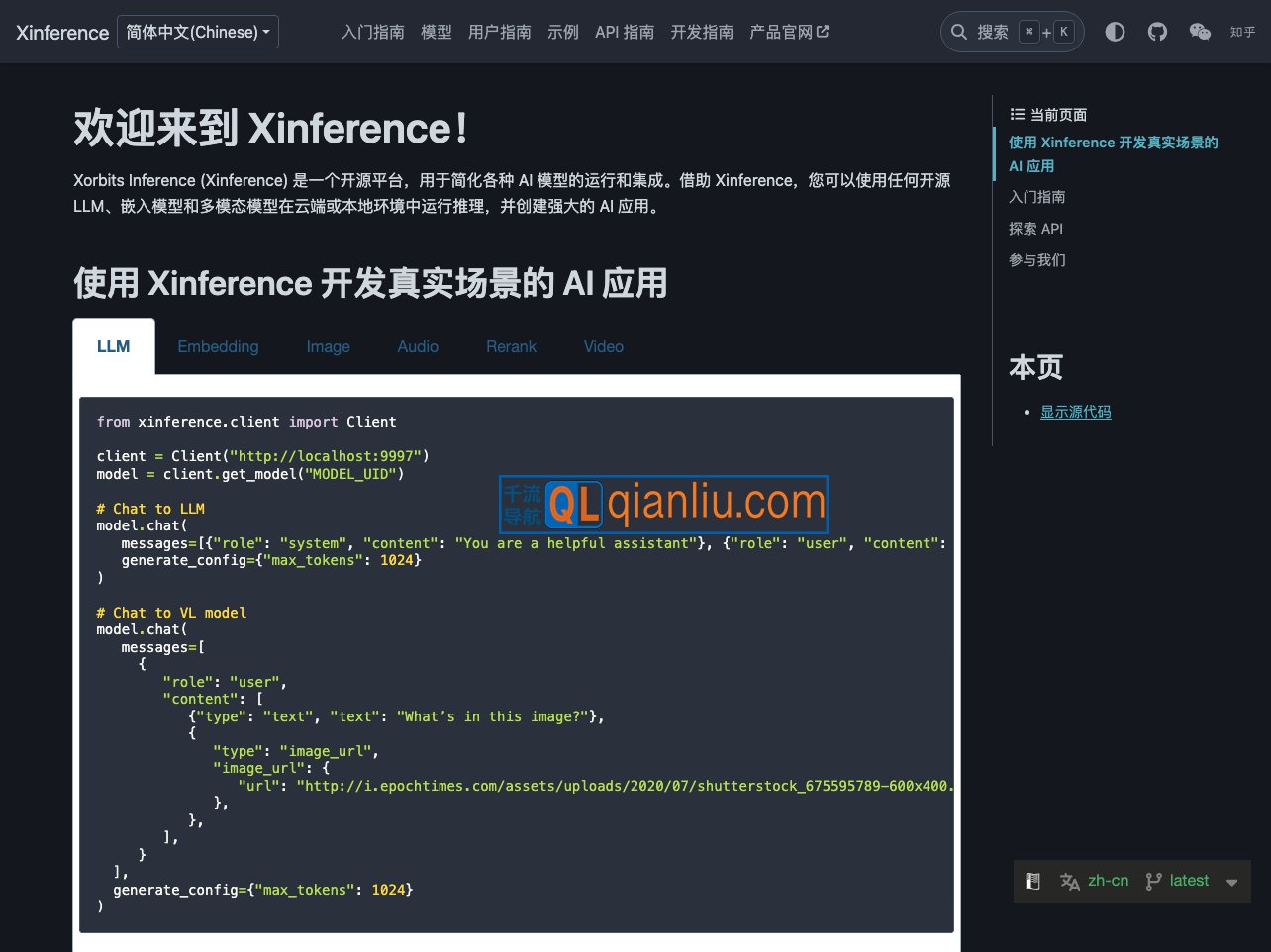

用户可通过命令行工具、RESTful API、CLI 或 WebUI 等方式与 Xinference 交互,支持异步请求与流式响应,满足多样化的调用需求。安装过程简洁,既可通过 pip 直接安装,也支持使用 Docker Compose 快速启动服务。

社区与开源协作

作为托管于 GitHub 的开源项目,Xinference 拥有活跃的开发者社区。用户可在 GitHub 提交问题或贡献代码,也可通过 Slack、Twitter 等渠道参与讨论。项目持续迭代,不断优化功能与稳定性。

凭借其灵活性、易用性与强大的扩展能力,Xinference 适用于企业级应用开发及科研场景中的 AI 模型部署需求,为 千流导航 用户提供高效可靠的推理解决方案。