SadTalker 是一个开源的人工智能项目,专注于通过音频驱动单张静态人像图像生成高度逼真的说话头像视频。该工具能够将一张普通的人脸照片与一段语音输入相结合,输出具有自然面部表情、唇部动作和头部姿态变化的动态视频,使静态图像呈现出“开口说话”的效果。

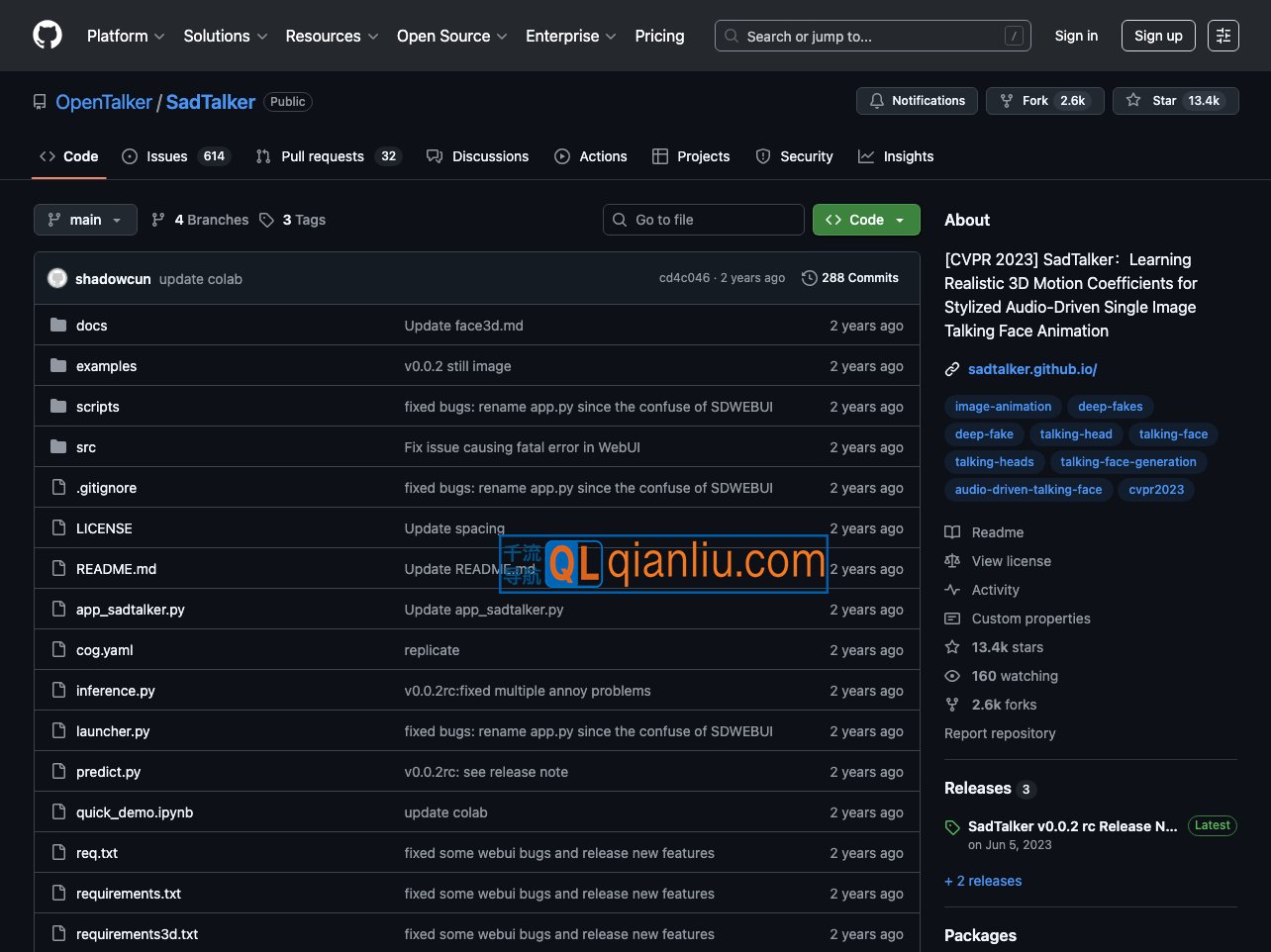

SadTalker官网入口网址:https://github.com/OpenTalker/SadTalker

该项目基于3D面部建模技术,利用音频信号提取3D运动参数,并通过3D渲染引擎合成最终视频。其核心模型包括 ExpNet 与 PoseVAE:前者负责从音频中预测精细的面部表情系数,后者则建模头部的姿态变化,二者协同工作以实现准确的口型同步和流畅的头部运动。SadTalker 支持多种生成模式(如静态、参考、缩放),并兼容中英文语音及歌唱音频输入,适应多样化的使用需求。

用户可通过多种方式使用 SadTalker。本地部署需安装 Python 3.8 或更高版本,并加载预训练模型运行生成脚本;对于希望快速体验的用户,项目亦提供 Hugging Face Spaces 和 Google Colab 的在线演示环境,无需配置复杂依赖。官方文档包含详细的安装指南、参数说明及常见问题解答,社区支持可通过 GitHub Issues 或 Discord 频道获取。

在应用场景方面,SadTalker 适用于虚拟主播、数字人客服、教育视频制作、个性化消息播报等领域。作为 MIT 许可下的开源项目,其代码、模型权重和使用示例均公开发布,允许个人与商业用途下的自由使用、修改与再分发。这种开放性使其在学术研究与工业应用中均获得广泛关注,成为语音驱动面部动画领域的重要工具之一。