SadTalker

SadTalker 是一个基于单张图像和音频生成说话人脸视频的模型,其核心功能是通过音频输入使静态图片中的图像动起来,并生成说话的虚拟人物。

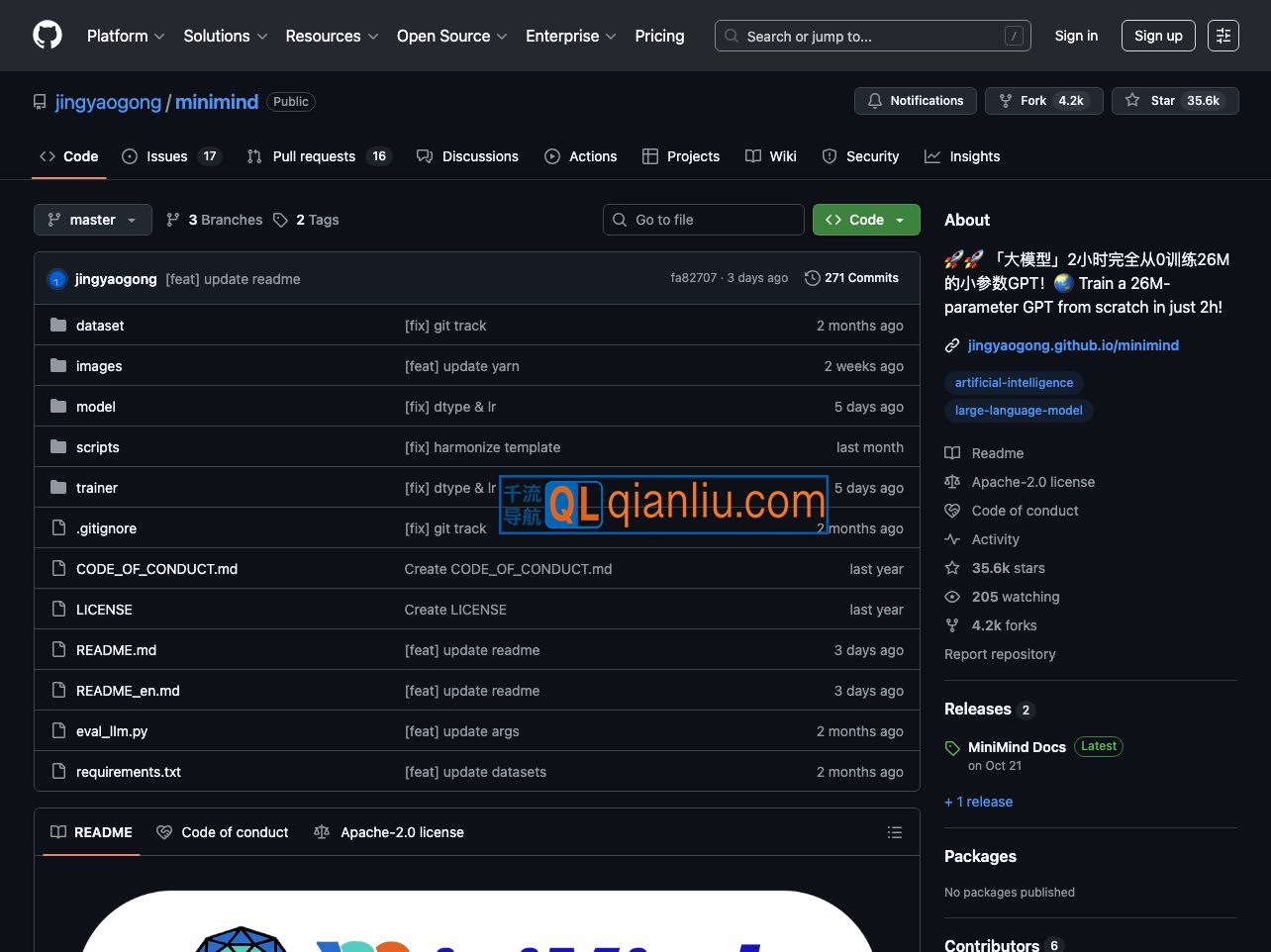

MiniMind项目旨在从零开始训练一个轻量级语言模型(LLM),并提供完整的训练、微调、推理和部署流程。

MiniMind 是一个开源的大语言模型(LLM)项目,由开发者 Jingyao Gong 创建,目标是通过极低的硬件成本与时间投入,使个人用户能够从零开始训练并理解大模型的基本原理。该项目完整复现了大语言模型的核心训练流程,同时显著压缩模型规模,最小版本参数量仅为 GPT-3 的约 1/7000,可在消费级 GPU 上完成训练。

MiniMind官网入口网址:https://github.com/jingyaogong/minimind

项目代码完全基于 PyTorch 从头实现,未依赖 Hugging Face Transformers 等第三方高级封装库,涵盖预训练、监督微调(SFT)、LoRA 微调以及强化学习人类反馈(RLHF)等关键阶段。所有训练脚本、数据处理工具和评估方法均公开提供,便于学习者深入掌握模型构建细节。

MiniMind 提供多个模型变体,包括基础系列 MiniMind2 以及支持图像输入的多模态扩展版本 MiniMind-V。训练好的模型可导出至 llama.cpp、vLLM、Ollama 等主流推理框架,便于在不同场景下部署和测试。

通过 MiniMind,用户不仅能复现端到端的语言模型训练过程,还能在有限资源下获得对大模型架构、优化方法及训练动态的直观理解。该项目在 千流导航 中被推荐为入门大模型开发的实用开源工具。