UI-TARS

一个开源的多模态代理模型,基于强大的视觉语言模型,能够有效执行虚拟世界中的多样化任务。具备 GUI、游戏、代码和工具使用等增强能力,能够无缝集成多种能力以完成复杂任务。

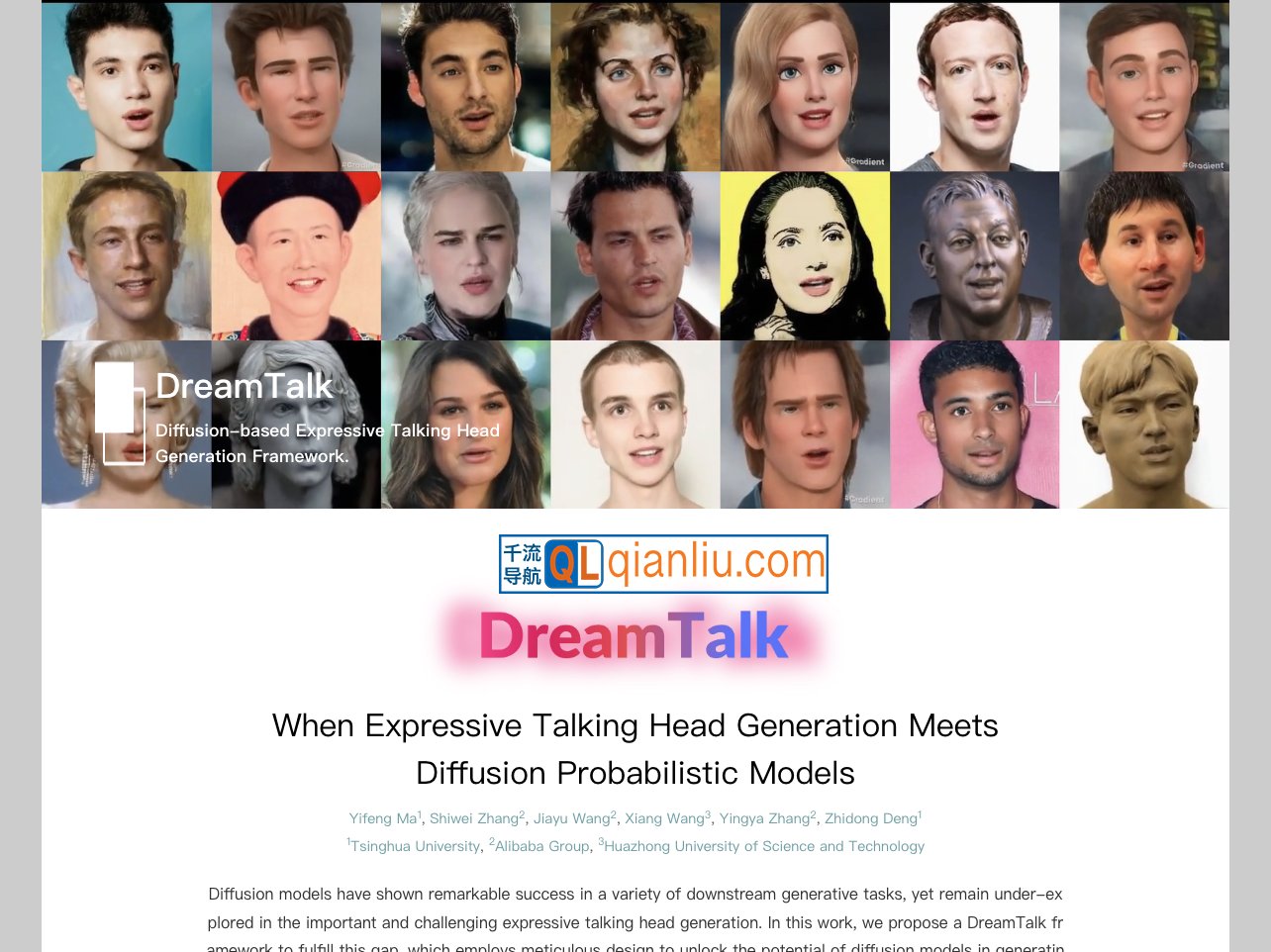

DreamTalk是由清华大学、阿里巴巴集团与华中科技大学共同研发的一项人工智能技术,基于扩散模型实现将静态人物照片转化为具有自然说话动作的动态虚拟形象。该技术通过分析输入音频,驱动图像中的人物生成与语音同步的面部表情和口型动作,适用于影视制作、人机交互、教育及跨文化交流等多种场景。

DreamTalk官网入口网址:https://dreamtalk-project.github.io

系统架构包含三个核心模块:降噪网络、风格感知唇部专家和风格预测器。降噪网络利用扩散机制生成高保真面部动画;风格感知唇部专家确保唇形动作贴合语音节奏与情感风格;风格预测器则直接从音频信号推断目标表情,降低对额外参考视频的依赖。这一组合使DreamTalk能够处理多语言、歌唱、背景噪声等复杂输入,并在非专业肖像图像上稳定运行。

DreamTalk以开源形式发布,研究人员与开发者可通过公开代码库获取模型实现细节与训练资源,进一步推动语音驱动面部动画技术的发展。该成果体现了人工智能在视觉生成与语音理解交叉领域的实质性进展,为千流导航用户提供了接触前沿AI能力的窗口。