Hallo

Hallo 是一个由复旦大学(Fudan University)开发的开源项目,专注于音频驱动的视觉合成技术,特别是用于人像动画生成。

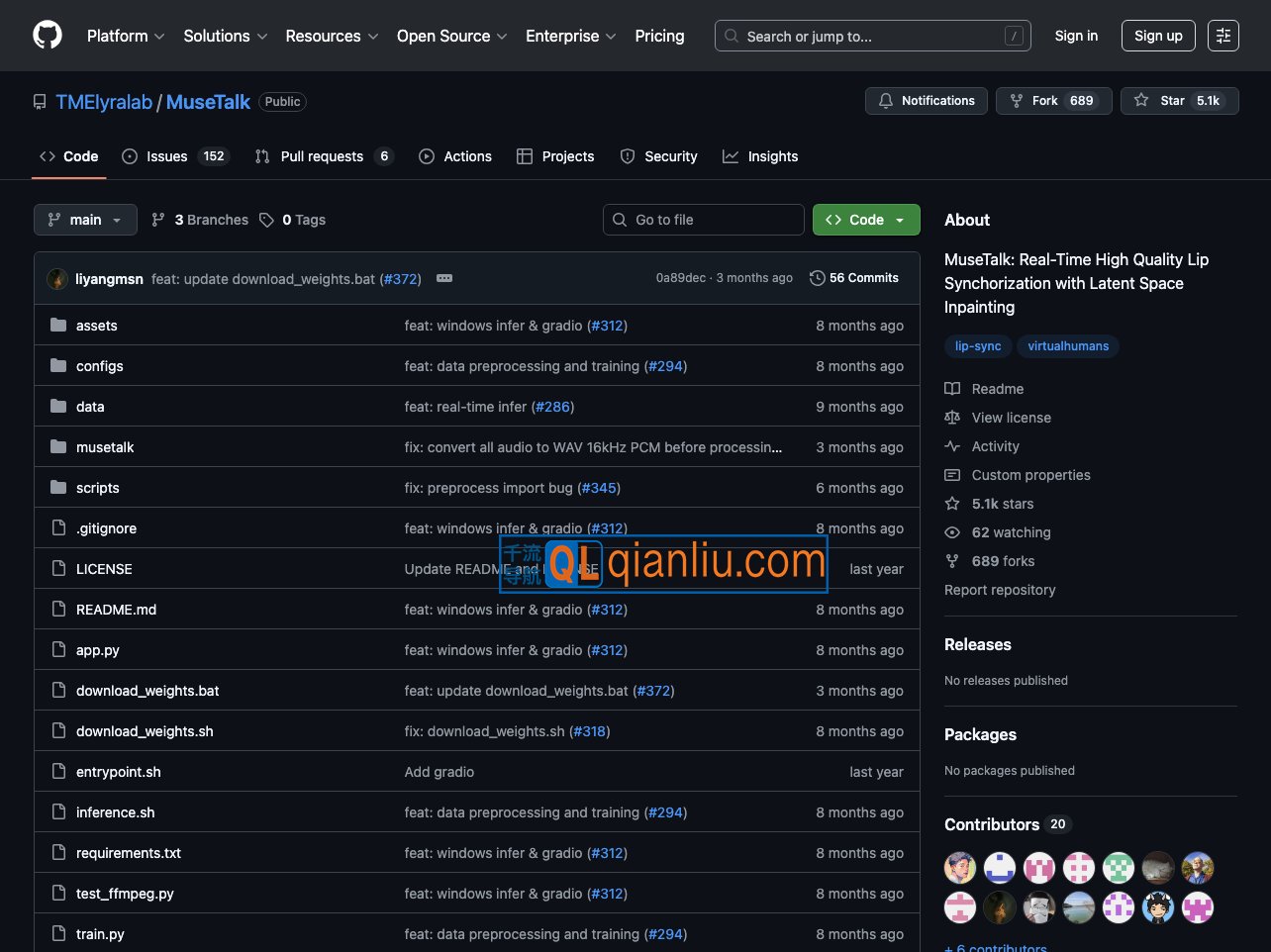

MuseTalk 是由腾讯音乐娱乐实验室(TME Lyra Lab)开发并开源的实时音频驱动唇形同步模型,专注于生成高保真、身份一致且口型精准匹配的数字人视频。该模型利用深度学习技术,根据输入的语音信号自动生成与之同步的面部动作,显著提升虚拟人物视频的真实感与自然度。

MuseTalk官网入口网址:https://github.com/TMElyralab/MuseTalk

在技术架构上,MuseTalk 基于 ft-mse-vae 潜在空间进行训练,并融合 Stable Diffusion 的 U-Net 结构,通过多尺度特征提取与选择性信息采样机制,实现高效的音频-视觉对齐。其推理速度在 NVIDIA Tesla V100 GPU 上可稳定达到 30fps 以上,满足实时应用场景的需求。

该模型支持中文、英文和日文等多种语言输入,适用于虚拟主播、视频配音、在线教育、数字人直播等多样化场景。用户可通过提供的 WebUI 界面上传参考视频与音频素材,灵活调整生成参数,快速产出高质量的同步视频内容。

MuseTalk 的代码、预训练模型及使用文档已在 GitHub 和 Hugging Face 平台公开,便于开发者部署、测试与二次开发。作为一项开放的技术成果,MuseTalk 为数字内容创作和虚拟人应用提供了可靠的技术基础,也促进了相关领域的社区协作与创新实践。