HiAgent

HiAgent是字节跳动旗下火山引擎推出的一款企业专属 AI 应用创新平台,旨在帮助企业快速构建和部署大模型应用,从而实现智能化转型。

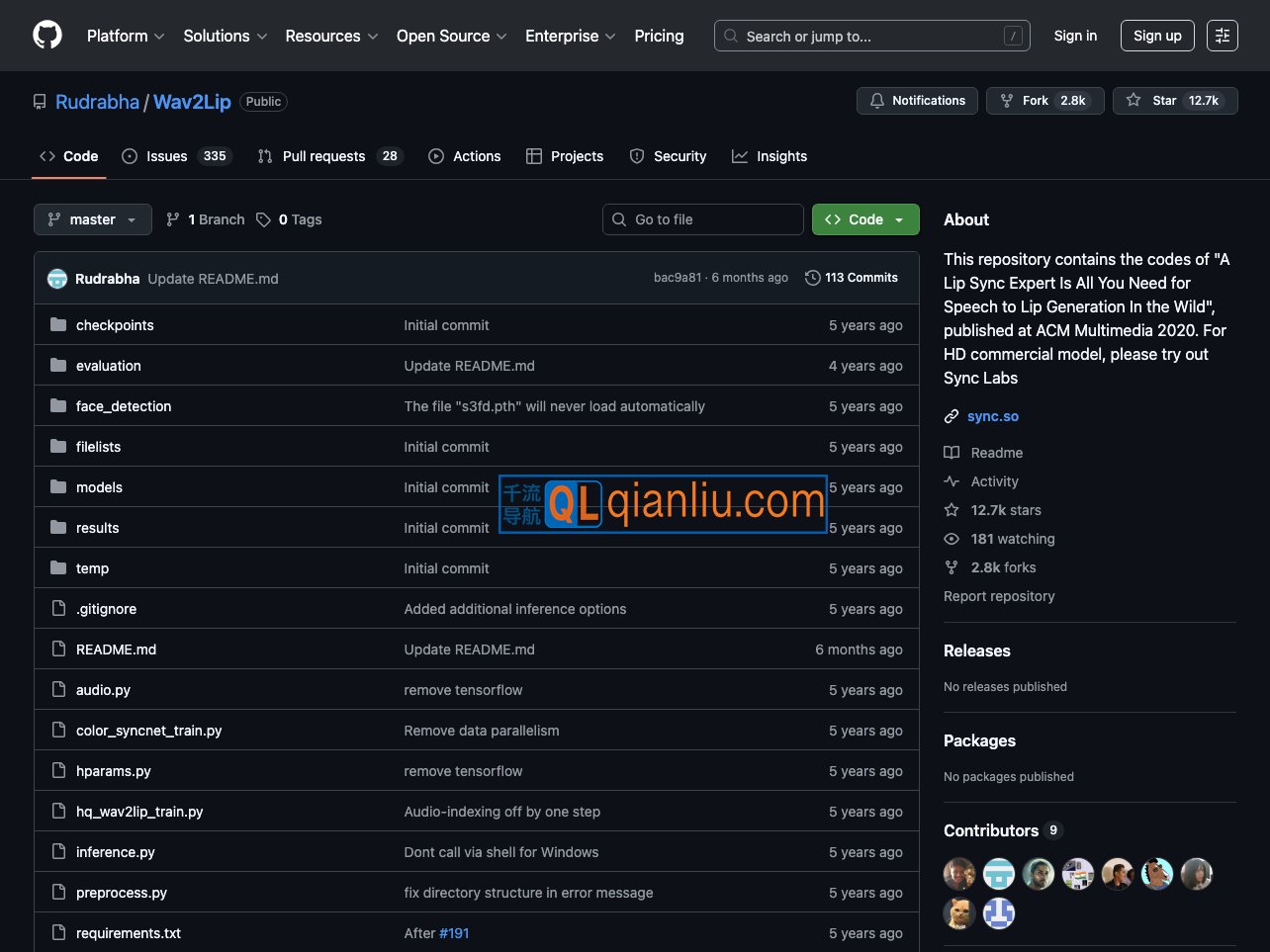

Wav2Lip 是由 Rudrabha/Wav2Lip 团队开发的开源项目,专注于实现视频中人物唇部动作与输入音频的高精度同步。该工具利用深度学习方法,将任意语音或音频信号与目标人脸视频进行匹配,生成自然、连贯的唇语同步效果。其适用范围广泛,可处理影视片段、动画角色或用户自拍等多种类型的人脸视频,并支持多种语言及不同的说话风格。

Wav2Lip官网入口网址:https://github.com/Rudrabha/Wav2Lip

Wav2Lip 的核心架构融合了生成对抗网络(GAN)与时序卷积网络(TCN),通过以下流程完成唇形同步:

凭借稳定的表现与良好的社区支持,Wav2Lip 已成为语音驱动面部动画领域的代表性工具,适合多媒体创作者、研究人员及开发者在 千流导航 探索应用。